فایل Robots.txt چیست؟ آموزش ایجاد فایل ربات robots.txt

سلام خوش آمدید به مقاله فایل Robots.txt چیست؟ همانطور که همه ما می دانیم، ربات های موتورهای جستجو برجسته ترین نقش را در آشنایی کامل یک سایت برای موتورهای جستجو دارند. گوگل به عنوان بزرگترین مرجع و گسترده ترین شبکه در این زمینه، بسیاری از ربات های خصوصی و عمومی را توسعه داده است. وب مسترهای موفق همیشه عملکرد و تغییرات این ربات ها را دنبال می کنند و طبق استانداردهای آنها حرکت می کنند.

اما چگونه این ربات ها به سایت های مختلف دسترسی پیدا می کنند؟ چگونه می توانیم دسترسی این ربات ها را به مطالب یا صفحات خاصی از سایت خود محدود کنیم یا به آنها دسترسی کامل بدهیم؟ برای این، یک تکنیک ساده اما فوق العاده مهم وجود دارد. این تکنیک استفاده از یک فایل متنی به نام Robots.txt است که می تواند برای درج دستورات در وب برای انجام کارهای مختلف از جمله مسدود کردن یا محدود کردن دسترسی به ربات های موتور جستجو استفاده شود.

اهمیت و بهینه سازی این فایل می تواند نقش بسیار مفیدی در پیشرفت سایت اینترنتی شما داشته باشد و برعکس بی دقتی در کار با آن به راحتی می تواند رتبه سایت شما را چندین برابر کند. در این مقاله قصد داریم شما را با ماهیت فایل های Robots.txt آشنا کنیم و از اهمیت بسیار زیاد آنها برای موفقیت بهتر در فرآیندهای سئو به شما بگوییم.

پیشنهاد میشود از مقاله آموزش سئو سایت دیدن کنید.

فایل Robots.txt چیست؟

Robots.txt در واقع یک فایل متنی ساده است که در مسیر اصلی سایت یا دایرکتوری ریشه شما قرار می گیرد. (همان هاست سایت شما) در واقع وظیفه این فایل ارائه بخش های قابل دسترسی برای دسترسی ربات و بخش های محدود شده یا با تعریف دقیق تر، بررسی و ثبت اطلاعات برای خزنده های وب (ربات های گوگل) ایجاد شده توسط موتورهای جستجو می باشد.

با قرار دادن دستورات خاص در این فایل، می توانید به ربات های موتورهای جستجو بگویید که کدام صفحات، کدام فایل ها و کدام بخش های سایت شما را جستجو و فهرست بندی کنند و کدام صفحات را نادیده بگیرند. به عبارت دیگر، اولین چیزی که ربات های موتورهای جستجو با آن مواجه می شوند، فایل Robots.txt است. خزنده های وب به محض مواجه شدن با این فایل شروع به بررسی محتویات و لیست داخل این فایل می کنند تا قسمت های قابل دسترسی را پیدا کنند.

همانطور که گفته شد این فایل باید در روت هاست شما قرار میگیرد. در این صورت آدرس دسترسی به این فایل به صورت زیر خواهد بود:

https://site.com/robots.txt

سوالات متدوال

اگر فایل robots.txt بدرستی آپلود نکنیم چه میشود؟

نتیجه این مورد به نوع مشکل بستگی دارد. در صورتی که فایل مذکور با فرمت استاندارد و صحیح ساخته نشده باشد و یا اطلاعات و دستورات داخل آن قابل شناسایی نباشد، ربات های موتور جستجو همچنان به اطلاعات سایت شما دسترسی پیدا کرده و ایندکس می کنند. به عبارت دیگر، ربات ها تنها زمانی رفتار خود را تغییر می دهند که دستور دقیق مربوط به آن رفتار را از طریق متن داخل این فایل دریافت کنند. در غیر این صورت به رفتار عادی خود یعنی خزیدن و ایندکس کردن تمامی قسمت های سایت ادامه می دهند.

اگر فایل robots.txt نداشته باشیم چهمیشود؟

اگر این فایل در هاست سایت شما آپلود نشود، خزنده ها و ربات های موتور جستجو به تمام صفحات عمومی دسترسی خواهند داشت و می توانند تمام محتوای سایت شما را ایندکس کنند.

فایل robots.txt یک فایل متنی با ساختار ساده است. نحوه کار این فایل با کمک دستورات پیش فرض و یکپارچه سازی کلمات کلیدی تعیین می شود. مهم ترین و رایج ترین دستورات مواردی مانند user-agent، Disallow، allow، crawl-delay و sitemap هستند که در زیر هر کدام را به صورت جداگانه شرح خواهیم داد.

User-Agent: این دستور برای تعیین اینکه آیا ربات ها و خزنده ها می توانند به قسمت های خاصی از سایت دسترسی داشته باشند؟ یا خیر. در این جهت استفاده می شود. با این دستورالعمل، میتوانید به همه رباتها دسترسی بدهید یا میتوانید با افزودن یک نام ربات خاص، دسترسی خزنده ای را فقط به آن ربات بدهید یا محدود کنید.

مثال: یک ربات وارد سایت شما می شود و می خواهد اطلاعات یک صفحه خاص را بررسی و جمع آوری کند، به عنوان مثال www.example.com/test. قبل از خزیدن در این صفحه، ربات ابتدا فایل robots.txt را بررسی می کند. به عنوان مثال، محتویات این فایل به شرح زیر است:

User-agent: *

User-agent: * به این معنی است که تمام قسمت های این سایت برای همه ربات ها و خزنده های موتورهای جستجو قابل دسترسی است. اما اگر می خواهید اطلاعات خود را فقط برای ربات خاصی مشخص کنید، باید به جای ستاره، نام دقیق آن ربات را قرار دهید.

مثال زیر را در نظر بگیرید. در این مثال، تنها روبات های گوگل حق دسترسی به صفحات سایت را دارند:

User-agent: Googlebot

Disallow and Allow: با کمک این دستورالعمل می توان مشخص کرد که کدام قسمت های سایت توسط User-agent یا ربات های تعیین شده بررسی و ایندکس شوند یا نه. همانطور که مشخص است، کد اجازه برای ایجاد دسترسی و از کد انکار برای محدود کردن دسترسی ربات استفاده می شود.

مثال: اگر فقط دستور “Disallow :/” را در فایل robots.txt قرار دهید، به ربات ها می گویید که نباید هیچ صفحه ای را در این سایت بازدید، خزیدن، یا فهرست بندی کنند. همچنین، اگر می خواهید به همه آنها دسترسی کامل بدهید، باید از دستور “Allow: /” استفاده کنید.

میتوانید فایلها، مسیرها، آدرسها و صفحات سایت خود را بهعنوان انتخابی تنظیم کنید تا فقط این قسمتها قابل دسترسی باشند یا برعکس. مثال ساده زیر را در نظر بگیرید:

Disallow: /wp-admin/

Allow: /contact-us/

مانند مثال بالا، مسیر دسترسی به پنل مدیریت وردپرس برای دسترسی ربات ها محدود است، اما صفحه تماس با ما قابل دسترسی است. بنابراین، این نوع دسترسی را می توان بسیار آسان و سریع مدیریت کرد.

Crawl-Delay: میتوانید رباتهای موتور جستجو را مجبور کنید تا با وارد کردن دستورالعمل تأخیر خزیدن یا نرخ تأخیر، مدت زمانی را که برای بررسی و فهرستبندی صفحات خود تعیین میکنید، منتظر بمانند. البته لازم به ذکر است که این دستور العمل بر روی برخی ربات ها از جمله Googlebot قابل استفاده نیست. برای فعال کردن این ویژگی در ربات گوگل، میتوانید نرخ زمان این مورد را از کنسول جستجوی گوگل در قسمت تنظیمات سایت تغییر دهید.

هدف آن کاهش تعداد درخواست های مکرر ربات ها به سرور سایت شما است. چنین اقدامی کمک زیادی به تسهیل فرآیندهای نمایه سازی می کند. برای استفاده از این دستور می توانید متن زیر را در فایل متنی robots.txt قرار دهید:

Crawl-Delay: 10

با قرار دادن این کد در robots.txt، در واقع به ربات های موتورهای جستجو مانند یاهو و بینگ می گویید که پس از هر فهرست دهی 10 ثانیه منتظر بمانند و صفحه دیگری را دوباره فهرست کنند. این کد برای موتور جستجوی Yandex کمی متفاوت عمل می کند. با وارد کردن این دستور در robots.txt، موتور جستجوی Yandex هر 10 ثانیه به تمام صفحات سایت دسترسی پیدا می کند. با تغییر عدد 10 به اعداد دیگر می توانید دوره مربوطه را کم یا زیاد کنید.

توجه: توجه داشته باشید که استفاده از دستورالعمل crawl-delay ممکن است در همه موارد نتیجه درستی نداشته باشد. به عنوان مثال، اگر نرخ تاخیر ربات را روی ده ثانیه تنظیم کنید، موتورهای جستجو فقط می توانند تقریباً 8600 صفحه از سایت شما را در روز بخزند و ایندکس کنند. در حالی که این خزش برای چنین سایت های بزرگی مقدار کمی نیست، اما برای سایت هایی با صفحات زیاد و محتوای زیاد روش مناسبی نیست. بنابراین قبل از استفاده از این محصول مراقب آن باشید.

نقشه سایت (sitemap): با تعیین دستورات مربوط به نقشه سایت در robots.txt، می توانید به موتورهای جستجو بگویید که چگونه فایل XML نقشه سایت خود را پیدا کرده و به آن دسترسی داشته باشند. اگرچه ابزارهای ویژه ای برای ثبت نقشه سایت در موتورهای جستجو وجود دارد، اما این روش نیز یکی از روش های ساده و کم دردسر برای این مشکل است. البته در هر شرایطی استفاده از ابزارهای وبمستر موتورهای جستجو مانند سرچ کنسول گوگل در اولویت قرار خواهد گرفت. اما اگر تصمیم دارید راه آسان را انتخاب کنید، فقط کد دستوری زیر را به فایل robots.txt اضافه کنید:

همانطور که می بینید، باید آدرس دقیق نقشه سایت خود را مانند مثال بالا در این خط وارد کنید.

نکته مهم: محتوای فایل robots.txt به حروف بزرگ و کوچک حساس است. به عنوان مثال، اگر کد Disallow: /File.php را در متن وارد کنید، محدودیت تنها زمانی اعمال می شود که فایلی به نام File.php در آن مسیر وجود داشته باشد. اما اگر فایل مورد نظر شما با نام file.php ذخیره شود، هیچ محدودیتی برای آن اعمال نخواهد شد. همچنین لازم به ذکر است که نام خود فایل robots.txt به حروف کوچک و بزرگ حساس است. این فایل باید با حروف کوچک و دقیقاً به صورت robots.txt ذخیره شود.

چطور فایل robots.txt بسازیم؟

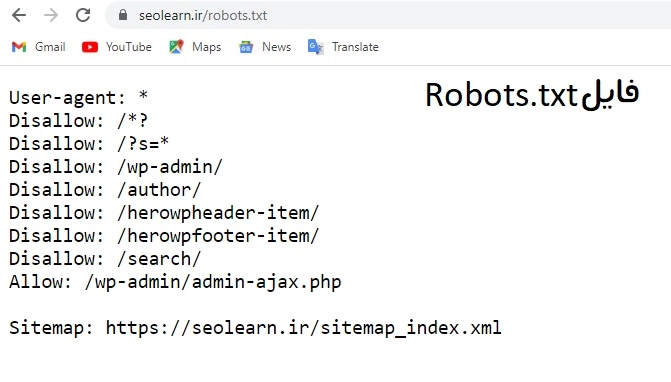

قبل از ایجاد این فایل، ابتدا مطمئن شوید که چنین فایلی از قبل در سرور سایت شما ایجاد نشده است. برای اطلاع از این موضوع کافی است آدرس سایت خود را وارد کرده و در انتها عبارت /robots.txt را تایپ کرده و Enter را فشار دهید.

مانند: https://seolearn.ir/robots.txt

اگر هنگام باز کردن این صفحه با خطای 404 مواجه شدید، به این معنی است که چنین فایلی ایجاد نشده است. اما اگر پس از ورود به این صفحه کد User-Agent را مشاهده کردید به این معنی است که سایت شما این فایل را دارد. در این صورت باید از طریق FTP یا کنترل پنل هاست سایت خود به قسمت مدیریت فایل بروید و فایل robots.txt را در روت اصلی هاست پیدا کنید. سپس باید آن را از طریق یک ویرایشگر متن آنلاین اجرا کنید و آن را ویرایش کنید. همچنین می توانید این فایل را دانلود کرده و در کامپیوتر خود ویرایش کنید و در نهایت فایل ذخیره شده را با فایل قبلی جایگزین کنید.

همچنین اگر این فایل در هاست سایت شما یافت نشد، کافی است یک فایل متنی txt از طریق Notepad ویندوز ایجاد کنید و آن را با نام robots (با حروف کوچک) ذخیره کنید. سپس دستورات مورد نیاز خود را وارد کرده و فایل را ذخیره کنید. در نهایت فایل آماده شده را با همان روش هایی که در بالا توضیح داده شد (از طریق FTP یا فایل منیجر کنترل پنل هاست) در روت اصلی سایت آپلود کنید.

سخن آخر

استفاده از فایل robots.txt مبتواند به سود/ضرر سایت شما باشد. باید طریق استفاده از آن را بطور کامل بلد باشید تا بتوانید به خوبی از آن استفاده کنید… هر سوالی داشتید بخش نظرات حتما بپرسید. خوشحالیم که تا انتهای مقاله فایل Robots.txt چیست؟ همراه ما بودید.

مقالات پیشنهادی:

درباره مهدی فاتحی فر

مهدی فاتحی فر هستم مدیر و موسس سئو لرن. سال ها هست که در زمینه سئو بصورت کاملا تخصصی فعالیت دارم. تا به حال توانسته ام تجربیات زیادی را در سئو کسب کنم، عاشق آموزش دادن سئو به همه علاقه مندان به این حوزه هستم.

سایر نوشته های مهدی فاتحی فر

دیدگاهتان را بنویسید